开发指南

浮点模型的要求

symbolic_trace

和 PyTorch 的量化训练类似,horizon_plugin_pytorch 基于 fx 设计和开发,因此,要求浮点模型必须是可以正确的完成 symbolic_trace 的

仅支持部分算子

由于 BPU 只支持数量有限的算子,因此,horizon_plugin_pytorch 只支持算子列表中的算子和基于 BPU 限制而内部特殊定义的特殊算子。

构建量化友好模型

浮点模型变为定点模型的过程存在一定的精度误差,越是量化友好的浮点模型, qat 精度提升越容易,量化后的精度也越高。一般而言,有以下几种情况会导致模型变得量化不友好:

-

使用有精度风险的算子。例如: softmax , layernorm 等(详见 op 文档),这类算子一般底层由查表或多个 op 拼接实现,容易发生掉点问题。

-

一次 forward 中多次调用同一算子。同一算子多次调用,对应的输出分布存在差异,但只会统计一组量化参数,当多次调用的输出分布差异过大时,量化误差会变大。

-

add , cat 等多输入算子的不同输入差异过大,可能造成较大误差。

-

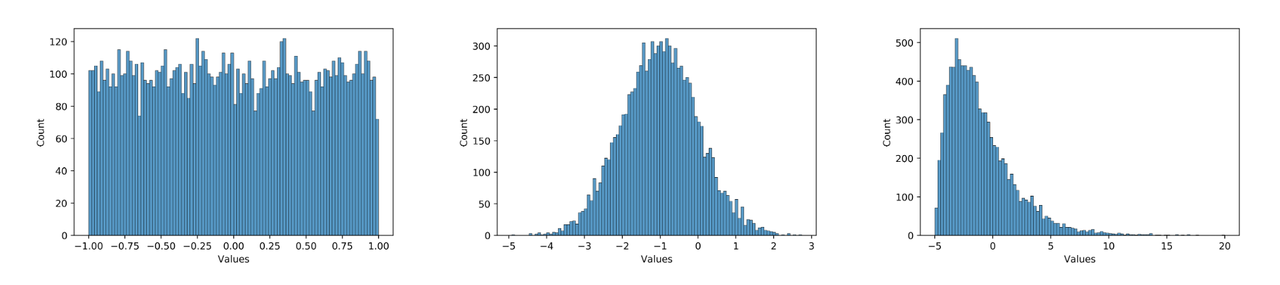

数据分布不合理。plugin 采用的是均匀对称量化,所以 0 均值的均匀��分布最好,应尽量避免长尾和离群点。同时,数值范围需要与量化 bit 相匹配,如果使用int8量化分布为 [-1000, 1000] 均匀分布的数据,那么精度显然也是不够的。例如,下面三个分布图,从左到右对量化的友好性依次递减,模型中大部分数值的分布应当为中间这种分布。在实际使用中,可以用 debug 工具查看模型 weight 和 feature map 的分布是否量化友好。因为模型冗余性的存在,有些看起来分布非常量化不友好的 op 并不会显著降低模型的最终精度,需要结合实际的 qat 训练难度和最后达到的量化精度综合考虑。

那么如何使得模型更加量化友好呢?具体来说:

-

尽量少使用精度风险过大的算子,详见 op 文档。

-

保证多次调用的共享算子每次调用的输出分布差异不要太大,或者将共享算子拆开分别单独使用。

-

避免多输入算子不同输入的数值范围差异过大。

-

使用 int16 量化数值范围和误差都非常大的 op 。可通过 debug 工具找到这类 op 。

-

通过调大 weight decay ,增加数据增强等方式防止模型过拟合。过拟合模型容易出现较大数值,且对输入非常敏感,轻微的误差可能导致输出完全错误。

-

使用 BN 。

-

对模型输入做关于0对称的归一化。

需要注意的是, qat 自身具有一定的调整能力,量化不友好并不代表不能量化,很多情况下,即使出现上面的不适合量化的现象,仍然可以量化得很好。因为上述建议也可能会导致浮点模型精度下降,所以应当在 qat 精度无法达标�时再尝试上述建议,尤其是 1 - 5 条建议,最后应当是在浮点模型精度和量化模型精度中找一个平衡点。

qconfig 详解

什么是 qconfig

模型的量化方式由 qconfig 决定,在准备 qat / calibration 模型之前,需要先给模型设置 qconfig。我们不推荐您自定义 qconfig,尽量只使用预定义好的qconfig变量,因为自定义 qconfig 需要对具体的处理器限制认知清晰,详细了解训练工具的工作原理,定义出错可能导致模型无法正常收敛、模型无法编译等问题,浪费大量时间和人力。

目前,Plugin 中维护了两个版本的qconfig,早期版本的 qconfig 将在不久的将来被废弃,我们只推荐您使用此文档中介绍的 qconfig 用法。

如何获取 qconfig

- 使用封装好的 qconfig 变量。这些 qconfig 存放在

horizon_plugin_pytorch/quantization/qconfig.py中��,可以适用于绝大多数情况。包括:

from horizon_plugin_pytorch.quantization.qconfig import (

default_calib_8bit_fake_quant_qconfig,

default_qat_8bit_fake_quant_qconfig,

default_qat_8bit_fixed_act_fake_quant_qconfig,

default_calib_8bit_weight_16bit_act_fake_quant_qconfig,

default_qat_8bit_weight_16bit_act_fake_quant_qconfig,

default_qat_8bit_weight_16bit_fixed_act_fake_quant_qconfig,

default_qat_8bit_weight_32bit_out_fake_quant_qconfig, # 参考算子列表,支持高精度输出的算子可以设置此 qconfig 获得更高的精度

default_calib_8bit_weight_32bit_out_fake_quant_qconfig, # 参考算子列表,支持高精度输出的算子可以设置此 qconfig 获得更高的精度

)

- 使用

get_default_qconfig接口。此接口较固定 qconfig 变量更灵活,我们推荐您对量化和硬件限制有清晰认知之后再使用。常用参数和解释如下:

from horizon_plugin_pytorch.quantization.qconfig import get_default_qconfig

qconfig = get_default_qconfig(

activation_fake_quant="fake_quant", # 支持 fake_quant, lsq, pact,常用 fake quant

weight_fake_quant="fake_quant", # 支持 fake_quant, lsq, pact,常用 fake quant

activation_observer="min_max", # 支持 min_max, fixed_scale, clip, percentile, clip_std, mse, kl

weight_observer="min_max", # 支持 min_max, fixed_scale, clip, percentile, clip_std, mse, kl

activation_qkwargs={

"dtype": qint16, # 由具体算子决定是否支持 int16

"is_sync_quantize": False, # 是否同步统计数据,默认关闭提升forward速度

"averaging_constant": 0.01 # 滑动平均系数,设置为0时,scale不更新

},

weight_qkwargs={ # 只支持 dtype = qint8, qscheme = torch.per_channel_symmetric, ch_axis = 0, 不建议做额外配置

"dtype": qint8,

"qscheme": torch.per_channel_symmetric,

"ch_axis": 0,

},

)

如何设置 qconfig

共有三种设置方法,我们推荐您使用前两种,最后一种设置方式将废弃。

- 直接设置 qconfig 属性。此方法优先级最高,其余方法不会覆盖直接设置的 qconfig。

model.qconfig = default_qat_8bit_fake_quant_qconfig

- qconfig 模板。在 prepare 接口上指定 qconfig setter 和 example_inputs,自动为模型设置 qconfig。

model = prepare_qat_fx(

model,

example_inputs=data,

qconfig_setter=default_qat_qconfig_setter,

)

- qconfig_dict。在 prepare_qat_fx 接口上指定 qconfig_dict。此用法将逐步废弃,如无兼容性需求,不推荐再使用,这里不展开介绍。

model = prepare_qat_fx(

model,

qconfig_dict={"": default_qat_qconfig_setter},

)

qconfig 模板

长期以来,配置 qconfig 出错的问题经常发生,因�此我们开发了 qconfig 模板。qconfig 模板基于 subclass trace 方案感知模型的图结构,并按设定的规则自动设置 qconfig,是我们最推荐的设置 qconfig 方法。用法如下:

qat_model = prepare_qat_fx(

model,

example_inputs=example_input, # 用来感知图结构

qconfig_setter=( # qconfig 模板,支持传入多个模板,优先级从高到低。

sensitive_op_qat_8bit_weight_16bit_act_qconfig_setter(table, ratio=0.2),

default_calibration_qconfig_setter,

)

)

模板的优先级低于直接给模型设置 qconfig 属性,如果模型在 prepare 之前已经使用 model.qconfig = xxx 进行了配置,那么模板将不会生效。如果没有特殊需求,我们不推荐将两者混合使用,这很容易引发低级错误。绝大多数情况下,我们推荐您使用模板和 model.qconfig = xxx 两种设置方式中的一种即可满足需求。

模板可分为三类:

- 固定模板。固定模板中 calibration / qat / qat_fixed_act_scale 区别在于使用的 observer 类型和 scale 更新逻辑,分别用于校准,qat 训练,固定 activation scale qat 训练。default 模板( default_calibration_qconfig_setter / default_qat_qconfig_setter / default_qat_fixed_act_qconfig_setter )会做三件事:首先,将可以设置的高精度输出都设置上,对于不支持高精度的输出将给出提示;然后,从 grid sample 算子的 grid 输入向前搜索,直到出现第一个 gemm 类算子或者QuantStub,将中间的所有算子都设置为 int16。根据经验这里的 grid 一般表达范围较宽,int8 有较大可能不满足精度需求;最后,将其余算子设置为 int8。int16 模板( qat_8bit_weight_16bit_act_qconfig_setter / qat_8bit_weight_16bit_fixed_act_qconfig_setter / calibration_8bit_weight_16bit_act_qconfig_setter )会做两件事:首先,将可以设置的高精度输出都设置上,对于不支持高精度的输出将给出提示;其次,将其余算子设置为 int16。

from horizon_plugin_pytorch.quantization.qconfig_template import (

default_calibration_qconfig_setter,

default_qat_qconfig_setter,

default_qat_fixed_act_qconfig_setter,

qat_8bit_weight_16bit_act_qconfig_setter,

qat_8bit_weight_16bit_fixed_act_qconfig_setter,

calibration_8bit_weight_16bit_act_qconfig_setter,

)

- 敏感度模板。敏感度模板有 sensitive_op_calibration_8bit_weight_16bit_act_qconfig_setter, sensitive_op_qat_8bit_weight_16bit_act_qconfig_setter, sensitive_op_qat_8bit_weight_16bit_fixed_act_qconfig_setter,三者的区别和固定模板中三者的区别一致,也是分别用于校准,qat 训练,固定 activation scale qat 训练。 敏感度模板的第一个输入是精度 debug 工具产生的敏感度结果,第二个参数可以指定 ratio 或 topk ,敏感度模板会将量化敏感度最高的 topk 个算子设置��为 int16。搭配固定模板,可以轻松实现混合精度调优。

from horizon_plugin_pytorch.quantization.qconfig_template import (

default_calibration_qconfig_setter,

default_qat_qconfig_setter,

default_qat_fixed_act_qconfig_setter,

qat_8bit_weight_16bit_act_qconfig_setter,

qat_8bit_weight_16bit_fixed_act_qconfig_setter,

calibration_8bit_weight_16bit_act_qconfig_setter,

sensitive_op_qat_8bit_weight_16bit_act_qconfig_setter,

sensitive_op_qat_8bit_weight_16bit_fixed_act_qconfig_setter,

sensitive_op_calibration_8bit_weight_16bit_act_qconfig_setter,

)

table = torch.load("output_0-0_dataindex_1_sensitive_ops.pt")

qat_model = prepare_qat_fx(

model,

example_inputs=example_input,

qconfig_setter=(

sensitive_op_qat_8bit_weight_16bit_fixed_act_qconfig_setter(table, ratio=0.2),

default_calibration_qconfig_setter,

)

)

- 自定义模板。自定义模板只有 ModuleNameQconfigSetter,需要传入模块名和对应 qconfig 的字典,一般用于设置 fixed scale 等特殊需求,可以和固定模板,敏感度模板搭配使用。

from horizon_plugin_pytorch.quantization.qconfig_template import (

default_calibration_qconfig_setter,

default_qat_qconfig_setter,

default_qat_fixed_act_qconfig_setter,

qat_8bit_weight_16bit_act_qconfig_setter,

qat_8bit_weight_16bit_fixed_act_qconfig_setter,

calibration_8bit_weight_16bit_act_qconfig_setter,

sensitive_op_qat_8bit_weight_16bit_act_qconfig_setter,

sensitive_op_qat_8bit_weight_16bit_fixed_act_qconfig_setter,

sensitive_op_calibration_8bit_weight_16bit_act_qconfig_setter,

ModuleNameQconfigSetter,

)

table = torch.load("output_0-0_dataindex_1_sensitive_ops.pt")

module_name_to_qconfig = {

"op_1": default_qat_8bit_fake_quant_qconfig,

"op_2": get_default_qconfig(

activation_observer="fixed_scale",

activation_qkwargs={

"dtype": qint16,

"scale": OP2_MAX / QINT16_MAX,

},

)

}

qat_model = prepare_qat_fx(

model,

example_inputs=example_input,

qconfig_setter=(

ModuleNameQconfigSetter(module_name_to_qconfig),

sensitive_op_qat_8bit_weight_16bit_fixed_act_qconfig_setter(table, ratio=0.2),

default_calibration_qconfig_setter,

)

)

Calibration 指南

在量化中,一个重要的步骤是确定量化参数,合理的初始量化参数能够显著提升模型精度并加快模型的收敛速度。Calibration 就是在浮点模型中插入 Observer,使用少量训练数据,在模型 forward 过程中统计各处的数据分布,以确定合理的量化参数的过程。虽然不做 Calibration 也可以进行量化训练,但一般来说,它对量化训练有益无害,所以推荐用户将此步骤作为必选项。

流程和示例

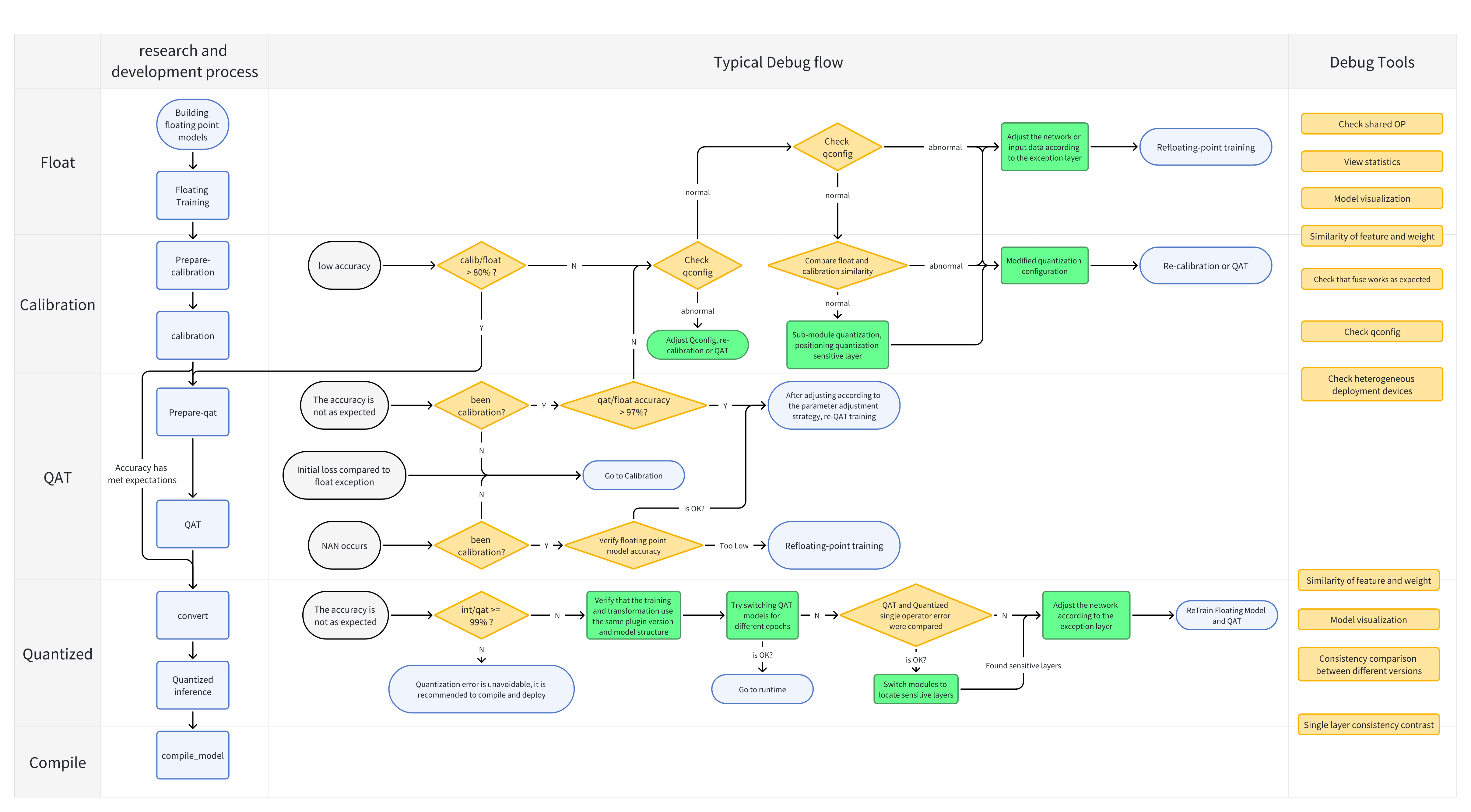

Calibration 与 QAT 的整体流程如下图所示:

下面分别介绍各个步骤:

-

构建并训练浮点模型。参考 horizon_plugin_pytorch 快速入门章节中的 获取浮点模型 小�节内容。

-

在浮点模型上插入 Observer 节点。参考 horizon_plugin_pytorch 快速入门章节中的 Calibration 小节内容。使用

prepare_qat_fx方法转化浮点模型前,需要为模型设置qconfig。model.qconfig = horizon.quantization.get_default_qconfig()get_default_qconfig可以为weight和activation设置不同的observer。目前,calibration 可选observer有 "min_max"、 "percentile"、 "mse"、 "kl" 和 "mix"。如无特殊需求,weight_observer推荐使用默认的 "min_max",activation_observer推荐使用 "mse"。特殊用法和调试技巧见下面的常见算法介绍。fake_quant参数对 Calibration 结果无影响,保留默认状态即可。def get_default_qconfig(

activation_fake_quant: Optional[str] = "fake_quant",

weight_fake_quant: Optional[str] = "fake_quant",

activation_observer: Optional[str] = "min_max",

weight_observer: Optional[str] = "min_max",

activation_qkwargs: Optional[Dict] = None,

weight_qkwargs: Optional[Dict] = None,

): -

设置

fake quantize状态为CALIBRATION。horizon.quantization.set_fake_quantize(model, horizon.quantization.FakeQuantState.CALIBRATION)fake quantize一共有三种状态,分别需要在QAT、calibration、validation前将模型的fake quantize设置为对应的状态。在 calibration 状态下,仅观测各算子输入输出的统计量。在 QAT 状态下,除观测统计量外还会进行伪量化操作。而在 validation 状态下,不会观测统计量,仅进行伪量化操作。class FakeQuantState(Enum):

QAT = "qat"

CALIBRATION = "calibration"

VALIDATION = "validation" -

calibration。把准备好的校准数据喂给模型,模型在 forward 过程中由 observer 观测相关统计量。

-

设置模型状态为 eval 并设置

fake quantize状态为VALIDATION。model.eval()

horizon.quantization.set_fake_quantize(model, horizon.quantization.FakeQuantState.VALIDATION) -

验证

calibration效果。如果效果满意,则可以直接将模型转为定点或在此基础上进行量化训练,不满意则调整calibration qconfig中的参数继续 calibration。

常用算法介绍

有关每个算子的参数说明,请参考文末 API 文档。

| 算法 | 速度排名 | 精度排名 | 易用性排名 |

|---|---|---|---|

| min_max | 1 | 5 | 1 |

| percentile | 2 | 4 | 4 |

| mse | 4 | 1 | 2 |

| kl | 5 | 2 | 3 |

| mix | 3 | 2 | 1 |

常用的几种校准方法性能如上表所示,数字越小越好,速度表示相同数据校准耗时,精度表示该方法在大多数模型上的校准效果,易用性表示该方法的调参复杂度。

对于同一模型而言,不同方法不同参数的精度/速度会存在较大差别,最新的一些研究工作也表明,没有一种方法可以在所有模型上都取得最好的精度,需要针对��地调整其参数。所以推荐用户对这几种校准方法都进行尝试。

-

min_max。此方法仅统计最大值最小值的滑动平均,用于快速确定 Batch size、average_constant 等通用参数,没有太多技巧。

-

percentile。此方法是所有方法中精度上限最高的,但也是调整起来最麻烦的,如果通过其他方法或本方法的默认参数就可以满足精度要求,那么不建议在调参上花太多时间。percentile 可调的参数一共有两个 bins、percentile。bins 越多,max 的候选项间隔越小,可供调整的粒度越细,但也意味着更高的计算耗时。建议先确定 percentile 再调整 bins,两者交替迭代缩小调参范围直至达到满意的效果。绝大部分情况下 bins 取 2048 提供的调整粒度完全足够,不需要单独调整这个参数。以下是一个模型的调参路径:

| 顺序 | percentile | bins | 精度 |

|---|---|---|---|

| 1 | 99.99 | 2048 | 53.75 |

| 2 | 99.99 | 4096 | 54.38 |

| 3 | 99.995 | 4096 | 16.25 |

| 4 | 99.985 | 4096 | 32.67 |

| 5 | 99.9875 | 4096 | 57.06 |

| 6 | 99.9875 | 8192 | 62.84 |

| 7 | 99.98875 | 8192 | 57.62 |

| 8 | 99.988125 | 8192 | 63.15 |

在这个例子中,可以看到仔细调整后,精度提升了大约 10%。 模型中不同 op 的输入输出之间存在很大差异,一组全局的 percentile 参数可能很难满足所有 op 的需求,对精度要求较高时,可以先通过上面的方法找到较好的全局参数,再通过 debug 工具找到误差较大的几个 op,单独为这几个 op 设置 percentile 参数,设置方式参照 qconfig 设置。下面列举几种常见的容易导致误差较大的数据分布:

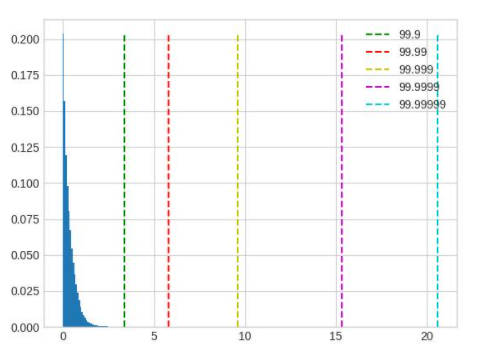

超长尾分布,percentile 的取值应当小一些,图中 99.9 是较好的取值。

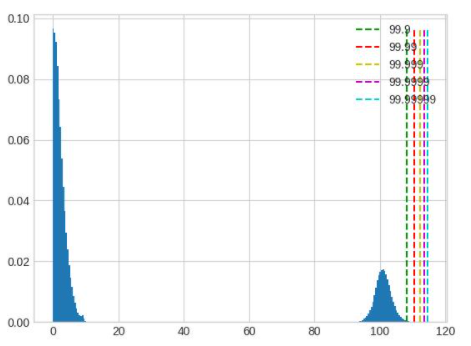

值域过大,且分布并不集中在一处,这种情况无论是保留尾部还是忽略尾部都会带来较大的精度损失,应该在训练浮点模型时通过调整 weight decay 等参数避免这种情况的出现。

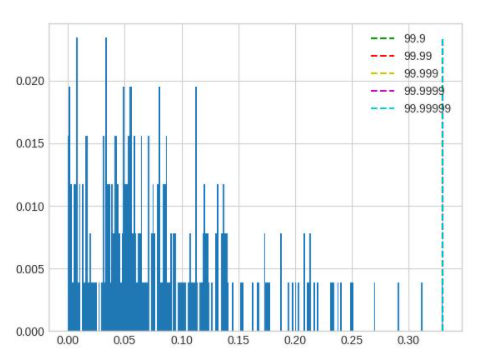

layernorm 的输出分布会呈现出若干集中度非常高的区域,此时 percentile 按照正常方法调整对于量化结果不会有任何影响,需要将 percentile 调整幅度增加。

-

mse。可调整的参数只有 stride,默认 stride 为 1,会逐步尝试最大值的 100 分位并选出量化反量化前后误差最小(L2 距离)的分位对应的值。此方法对大模型耗时较高,在合理范围内调大 stride 可以在保证精度的前提下减少耗时,stride 调整过大会影响精度。注意,调整此方法的参数只能优化耗时,并不能显著提升精度。

-

kl。可调的参数一共有两个 bin 和 update_interval。由于此方法耗时过长,不建议调整默认 bin,update_interval 默认为 1,调大可以减少耗时,但需要保证 update_interval 小于总的 calibration step,否则无法得到正常的量化参数�。

-

mix。此方法为混合校准,对于每一个需要统计的地方,都会尝试 percentile 方法的不同参数,选出量化反量化前后误差最小(L2 距离)的方法。自动化程度较高,没有需要调整的参数。

调参技巧

-

calibration 数据越多越好,但因为边际效应的存在,当数据量大到一定程度后,对精度的提升将非常有限。如果训练集较小,可以全部用来 calibration,如果训练集较大,可以结合 calibration 耗时挑选大小合适的子集,建议至少进行 10 - 100 个 step 的校准。

-

数据可以做水平翻转这类 augmentation,不要做马赛克这种 augmentation。尽量使用 infer 阶段的前处理 + 训练数据进行校准。

-

Batch size 尽可能大,如果数据噪声较大或模型离群点较多,可以适当减小。此参数应当在尝试 min max 方法时确定。

-

average_constant 表示每个 step 对最大值最小值的影响,average_constant 越小,当前 step 的影响越小,历史滑动均值的影响越大。该参数需要结合数据量在 0.01 ~ 0.5 之间调整。当数据量充足时(step > 100),average_constant 取 0.01,数据量不足时,average_constant 酌情增加,极端情况下,只有 2 个 step 的数据,average_constant 取 0.5。此参数应当在尝试 min max 方法时确定,之后其他方法都沿用此参数。

-

calibration 模型精度较好时,固定 feature map 的量化参数进行 QAT 训练可以取得更好的效果,精度较差时,则不能固定 calibration 得到的量化参数。关于精度是好还是坏,没有明确的标准,需要去尝试。比如:某模型精度为 100,如果 calibration 精度为 50,那么精度肯定称不上好,但如果 calibration 精度为 95,那么这个精度是否可以达到固定 feature map 量化参数的程度就需要尝试了,通常做法是固定与不固定都做实验进行对比。

-

优先尝试 min max 方法,该方法是速度最快的,用来跑通 calibration 流程,调整并确定 batch size 和 average_constant 两个参数,接着分别尝试 percentile、kl、mse 和 mix 四种方法并选取效果最好的方法。

Observer 参数文档

class horizon_plugin_pytorch.quantization.observer_v2.KLObserver(bins: int = 512, update_interval: int = 1, averaging_constant: float = 0.01, ch_axis: int = - 1, dtype: Union[torch.dtype, horizon_plugin_pytorch.dtype.QuantDType] = 'qint8', qscheme: torch.qscheme = torch.per_tensor_symmetric, quant_min: int = None, quant_max: int = None, is_sync_quantize: bool = False, factory_kwargs: Dict = None)

KL observer. KL observer based on histogram. Histogram is calculated online and won’t be saved.

参数

-

bins – Number of histograms bins.

-

update_interval – Interval of computing KL entropy and update min/max. KLObserver will constantly collect histograms of activations, but only perform KL calculation when update_interval is satisfied. if it is set to 1, KL entropy will be computed every forward step. Larger interval guarantees less time and does no harm to calibration accuracy. Set it to the total calibration steps can achieve best performance. update_interval must be no greater than total calibration steps, otherwise no min/max will be computed.

-

averaging_constant – Averaging constant for min/max.

-

ch_axis – Channel axis.

-

dtype – Quantized data type.

-

qscheme – Quantization scheme to be used.

-

quant_min – Min quantization value. Will follow dtype if unspecified.

-

quant_max – Max quantization value. Will follow dtype if unspecified.

-

is_sync_quantize – If sync statistics when training with multiple devices.

-

factory_kwargs – kwargs which are passed to factory functions for min_val and max_val.

forward(x_orig)

Defines the computation performed at every call.

Should be overridden by all subclasses.

Although the recipe for forward pass needs to be defined within this function, one should call the Module instance afterwards instead of this since the former takes care of running the registered hooks while the latter silently ignores them.

class horizon_plugin_pytorch.quantization.observer_v2.MSEObserver(stride: int = 1, averaging_constant: float = 0.01, ch_axis: int = - 1, dtype: Union[torch.dtype, horizon_plugin_pytorch.dtype.QuantDType] = 'qint8', qscheme: torch.qscheme = torch.per_tensor_symmetric, quant_min: int = None, quant_max: int = None, is_sync_quantize: bool = False, factory_kwargs: Dict = None)

MSE observer.

Observer module for computing the quantization parameters based on the Mean Square Error (MSE) between the original tensor and the quantized one.

This observer linear searches the quantization scales that minimize MSE.

参数

-

stride – Searching stride. Larger value gives smaller search space, which means less computing time but possibly poorer accuracy. Default is 1. Suggests no greater than 20.

-

averaging_constant – Averaging constant for min/max.

-

ch_axis �– Channel axis.

-

dtype – Quantized data type.

-

qscheme – Quantization scheme to be used.

-

quant_min – Min quantization value. Will follow dtype if unspecified.

-

quant_max – Max quantization value. Will follow dtype if unspecified.

-

is_sync_quantize – If sync statistics when training with multiple devices.

-

factory_kwargs – kwargs which are passed to factory functions for min_val and max_val.

forward(x_orig)

Defines the computation performed at every call.

Should be overridden by all subclasses.

Although the recipe for forward pass needs to be defined within this function, one should call the Module instance afterwards instead of this since the former takes care of running the registered hooks while the latter silently ignores them.

class horizon_plugin_pytorch.quantization.observer_v2.MinMaxObserver(averaging_constant: float = 0.01, ch_axis: int = - 1, dtype: Union[torch.dtype, horizon_plugin_pytorch.dtype.QuantDType] = 'qint8', qscheme: torch.qscheme = torch.per_tensor_symmetric, quant_min: int = None, quant_max: int = None, is_sync_quantize: bool = False, factory_kwargs: Dict = None)

Min max observer.

This observer computes the quantization parameters based on minimums and maximums of the incoming tensors. The module records the moving average minimum and maximum of incoming tensors, and uses this statistic to compute the quantization parameters.

参数

-

averaging_constant – Averaging constant for min/max.

-

ch_axis – Channel axis.

-

dtype – Quantized data type.

-

qscheme – Quantization scheme to be used.

-

quant_min – Min quantization value. Will follow dtype if unspecified.

-

quant_max – Max quantization value. Will follow dtype if unspecified.

-

is_sync_quantize – If sync statistics when training with multiple devices.

-

factory_kwargs – kwargs which are passed to factory functions for min_val and max_val.

forward(x_orig)

Record the running minimum and maximum of x.

class horizon_plugin_pytorch.quantization.observer_v2.MixObserver(averaging_constant: float = 0.01, ch_axis: int = - 1, dtype: Union[torch.dtype, horizon_plugin_pytorch.dtype.QuantDType] = 'qint8', qscheme: torch.qscheme = torch.per_tensor_symmetric, quant_min: int = None, quant_max: int = None, is_sync_quantize: bool = False, factory_kwargs: Dict = None)

Mix observer.

This observer computes the quantization parameters based on multiple calibration methods and selects the quantization parameters with the smallest quantization error.

参数

-

averaging_constant – Averaging constant for min/max.

-

ch_axis – Channel axis.

-

dtype – Quantized data type.

-

qscheme – Quantization scheme to be used.

-

quant_min – Min quantization value. Will follow dtype if unspecified.

-

quant_max – Max quantization value. Will follow dtype if unspecified.

-

is_sync_quantize – If sync statistics when training with multiple devices.

-

factory_kwargs – kwargs which are passed to factory functions for min_val and max_val.

forward(x_orig)

Defines the computation performed at every call.

Should be overridden by all subclasses.

Although the recipe for forward pass needs to be defined within this function, one should call the Module instance afterwards instead of this since the former takes care of running the registered hooks while the latter silently ignores them.

class horizon_plugin_pytorch.quantization.observer_v2.PercentileObserver(percentile: float = 99.99, bins: int = 2048, averaging_constant: float = 0.01, ch_axis: int = - 1, dtype: Union[torch.dtype, horizon_plugin_pytorch.dtype.QuantDType] = 'qint8', qscheme: torch.qscheme = torch.per_tensor_symmetric, quant_min: int = None, quant_max: int = None, is_sync_quantize: bool = False, factory_kwargs: Dict = None)

Percentile observer.

Percentile observer based on histogram. Histogram is calculated online and won’t be saved. The minimum and maximum are moving averaged to compute the quantization parameters.

参数

-

percentile – Index percentile of histrogram

-

bins – Number of histograms bins.

-

averaging_constant – Averaging constant for min/max.

-

ch_axis – Channel axis.

-

dtype – Quantized data type.

-

qscheme – Quantization scheme to be used.

-

quant_min – Min quantization value. Will follow dtype if unspecified.

-

quant_max – Max quantization value. Will follow dtype if unspecified.

-

is_sync_quantize – If sync statistics when training with multiple devices.

-

factory_kwargs – kwargs which are passed to factory functions for min_val and max_val.

forward(x_orig)

Defines the computation performed at every call.

Should be overridden by all subclasses.

Although the recipe for forward pass needs to be defined within this function, one should call the Module instance afterwards instead of this since the former takes care of running the registered hooks while the latter silently ignores them.

class horizon_plugin_pytorch.quantization.MovingAverageMinMaxObserver(averaging_constant=0.01, dtype=torch.qint8, qscheme=torch.per_tensor_symmetric, quant_min=None, quant_max=None, is_sync_quantize=False, factory_kwargs=None)

MovingAverageMinMax Observer.

Observer module for computing the quantization parameters based on the moving average of the min and max values.

This observer computes the quantization parameters based on the moving averages of minimums and maximums of the incoming tensors. The module records the average minimum and maximum of incoming tensors, and uses this statistic to compute the quantization parameters.

参数

-

averaging_constant – Averaging constant for min/max.

-

dtype – Quantized data type

-

qscheme – Quantization scheme to be used, only support per_tensor_symmetric scheme

-

reduce_range – Reduces the range of the quantized data type by 1 bit

-

quant_min – Minimum quantization value.

-

quant_max – Maximum quantization value.

-

is_sync_quantize – Whether use sync quantize

-

factory_kwargs – Arguments for register data buffer

forward(x_orig)

Record the running minimum and maximum of x.

class horizon_plugin_pytorch.quantization.MovingAveragePerChannelMinMaxObserver(averaging_constant=0.01, ch_axis=0, dtype=torch.qint8, qscheme=torch.per_channel_symmetric, quant_min=None, quant_max=None, is_sync_quantize=False, factory_kwargs=None)

MovingAveragePerChannelMinMax Observer.

Observer module for computing the quantization parameters based on the running per channel min and max values.

This observer uses the tensor min/max statistics to compute the per channel quantization parameters. The module records the running minimum and maximum of incoming tensors, and uses this statistic to compute the quantization parameters.

参数

-

averaging_constant – Averaging constant for min/max.

-

ch_axis – Channel axis

-

dtype – Quantized data type

-

qscheme – Quantization scheme to be used, Only support per_channel_symmetric

-

quant_min – Minimum quantization value.

-

quant_max – Maximum quantization value.

-

is_sync_quantize – whether use sync quantize

-

factory_kwargs – Arguments for register data buffer

forward(x_orig)

Defines the computation performed at every call.

Should be overridden by all subclasses.

Although the recipe for forward pass needs to be defined within this function, one should call the Module instance afterwards instead of this since the former takes care of running the registered hooks while the latter silently ignores them.

量化训练指南

量化训练通过在模型中插入一些伪量化节点,从而使得通过量化训练得到的模型转换成定点模型时尽可能减少精度损失。 量化训练和传统的模型训练无异,开发者可以从零开始,搭建一个伪量化模型,然后对该伪量化模型进行训练。 由于部署的硬件平台有诸多限制,对于开发者来说,搞清这些限制,并且根据这些限制搭建伪量化模型门槛较高。量化训练工具通过在开发者提供的浮点模型上根据部署平台的限制自动插入伪量化量化算子的方法,降低开发者开发量化模型的门槛。

量化训练由于施加了各种限制,因此,一般来说,量化训练比纯浮点模型的训练更加困难。量化训练工具的目标是降低量化训练的难度,降低量化模型部署的工程难度。

流程和示例

虽然量化训练工具不强制要求用户从一个预训练的浮点模型开始,但是,经验表明,通常从预训练的高精度浮点模型开始量化训练能大大降低量化训练的难度。

from horizon_plugin_pytorch.quantization import get_default_qconfig

# 将模型转为 QAT 状态

default_qat_8bit_fake_quant_qconfig = get_default_qconfig(

activation_fake_quant="fake_quant",

weight_fake_quant="fake_quant",

activation_observer="min_max",

weight_observer="min_max",

activation_qkwargs=None,

weight_qkwargs={

"qscheme": torch.per_channel_symmetric,

"ch_axis": 0,

},

)

default_qat_out_8bit_fake_quant_qconfig = get_default_qconfig(

activation_fake_quant=None,

weight_fake_quant="fake_quant",

activation_observer=None,

weight_observer="min_max",

activation_qkwargs=None,

weight_qkwargs={

"qscheme": torch.per_channel_symmetric,

"ch_axis": 0,

},

)

qat_model = prepare_qat_fx(

float_model,

{

"": default_qat_8bit_fake_quant_qconfig,

"module_name": {

"classifier": default_qat_out_8bit_fake_quant_qconfig,

},

},

).to(device)

# 加载 Calibration 模型中的量化参数

qat_model.load_state_dict(calib_model.state_dict())

# 进行量化感知训练

# 作为一个 filetune 过程,量化感知训练一般需要设定较小的学习率

optimizer = torch.optim.SGD(

qat_model.parameters(), lr=0.0001, weight_decay=2e-4

)

for nepoch in range(epoch_num):

# 注意此处对 QAT 模型 training 状态的控制方法

qat_model.train()

set_fake_quantize(qat_model, FakeQuantState.QAT)

train_one_epoch(

qat_model,

nn.CrossEntropyLoss(),

optimizer,

None,

train_data_loader,

device,

)

# 注意此处对 QAT 模型 eval 状态的控制方法

qat_model.eval()

set_fake_quantize(qat_model, FakeQuantState.VALIDATION)

# 测试 qat 模型精度

top1, top5 = evaluate(

qat_model,

eval_data_loader,

device,

)

print(

"QAT model: evaluation Acc@1 {:.3f} Acc@5 {:.3f}".format(

top1.avg, top5.avg

)

)

# 测试 quantized 模型精度

quantized_model = convert_fx(qat_model.eval()).to(device)

top1, top5 = evaluate(

quantized_model,

eval_data_loader,

device,

)

print(

"Quantized model: evaluation Acc@1 {:.3f} Acc@5 {:.3f}".format(

top1.avg, top5.avg

)

)

由于部署平台的底层限制,QAT 模型无法完全代表最终上板精度,请务必监控 quantized 模型精度,确保 quantized 模型精度正常,否则可能出现模型上板掉点问题。

由上述示例代码可以看到,与传统的纯浮点模型训练相比,量化训练多了两个步骤:

- prepare_qat_fx

- 加载 Calibration 模型参数

prepare_qat_fx

这一步骤的目标是对浮点网络进行变换,插入伪量化节点。

加载 Calibration 模型参数

通过加载 Calibration 得到的伪量化参数,来获得一个较好的初始化。

训练迭代

至此,完成了伪量化模型的搭建和参数的初始化,然后就可以进行常规的训练迭代和模型参数更新,并且监控 quantized 模型精度。

伪量化算�子

量化训练和传统的浮点模型的训练主要区别在于插入了伪量化算子,并且,不同量化训练算法也是通过伪量化算子来体现的,因此,这里介绍一下伪量化算子。

由于 BPU 只支持对称量化,因此,这里以对称量化为例介绍。

伪量化过程

以 int8 量化训练为例,一般来说,伪量化算子的计算过程如下:

fake_quant_x = clip(round(x / scale),-128, 127) * scale

和 Conv2d 通过训练来优化 weight, bias 参数类似,伪量化算子要通过训练来优化 scale 参数。 然而,由于 round 作为阶梯函数,其梯度为 0,从而导致了伪量化算子无法直接通过梯度反向传播的方式进行训练。解决这一问题,通常有两种方案:基于统计的方法和基于“学习”的方法。

基于统计的方法

量化地目标是把 Tensor 中的浮点数通过 scale 参数均匀地映射到 int8 表示的 [-128, 127] 的范围上。既然是均匀映射,那么很容易得到 scale 的计算方法:

def compute_scale(x: Tensor):

xmin, xmax = x.max(), maxv = x.min()

return max(xmin.abs(), xmax.abs()) / 256.0

由于 Tensor 中数据分布不均匀以及外点问题,又衍生了不同的计算 xmin 和 xmax 的方法。可以参考 MovingAverageMinMaxObserver 等。

在工具中的使用方法请参考 default_qat_8bit_fake_quant_qconfig 及其相关接口。

基于学习的方法

虽然 round 的梯度为 0,研究者通过实验发现,在该场景下,如果直接设置其梯度为 1 也可以使得模型收敛到预期的精度。

def round_ste(x: Tensor):

return (x.round() - x).detach() + x

在工具中的使用方法请参考 default_qat_8bit_lsq_quant_qconfig 及其相关接口。

有兴趣进一步了解的用户可以参考如下论文:Learned Step Size Quantization

异构模型指南

异构模型介绍

异构模型是部署时一部分运行在 BPU 上,一部分运行在 CPU 上的模型,而非异构模型部署时则完全运行在 BPU 上。通常情况下,以下两类模型在部署时会成为异构模型:

-

包含 BPU 不支持算子的模型。

-

由于量化精度误差过大,用户指定某些算子运行在 CPU 上的模型。

使用流程

通过 prepare 将浮点模型转为 QAT 模型,训练之后导出为 onnx 格式模型,由 hb_mapper 工具转为 bin 模型。

用户可以通过 convert 过程得到异构定点模型,用于模型精度评测。

算子限制

由于异构模型对接的是 horizon_nn,因此,其算子的支持情况和 horizon_nn 相同。

主要接口参数说明

horizon_plugin_pytorch.quantization.prepare_qat_fx

- 设置

hybrid=True来开启异构模型功能。 - 用户可以通过设置

hybrid_dict参数来强制指定某些 BPU 支持的算子跑在 CPU 上。

def prepare_qat_fx(

model: Union[torch.nn.Module, GraphModule],

qconfig_dict: Dict[str, Any] = None,

prepare_custom_config_dict: Dict[str, Any] = None,

optimize_graph: bool = False,

hybrid: bool = False,

hybrid_dict: Dict[str, List] = None,

) -> ObservedGraphModule:

"""Prepare QAT 模型

`model`: torch.nn.Module 或 GraphModule(使用 fuse_fx 后的模型)

`qconfig_dict`: 定义 Qconfig。如果除了 qconfig_dict 以外,还使用了 eager mode 在 module 内定义 qconfig 的方式,则 module 内定义的 qconfig 优先生效。qconfig_dict 的配置格式如下:

qconfig_dict = {

# 可选,全局配置

"": qconfig,

# 可选,按 module 类型配置

"module_type": [(torch.nn.Conv2d, qconfig), ...],

# 可选,按 module 名配置

"module_name": [("foo.bar", qconfig),...],

# 优先级:global < module_type < module_name < module.qconfig

# 非 module 类型的算子的 qconfig 默认与其父 module 的 qconfig 保持一致,如果需要单独设置,请将这部分单独封装成 module。

}

`prepare_custom_config_dict`: 自定义配置字典

prepare_custom_config_dict = {

# 暂时只支持 preserved_attributes。一般而言会自动保留所有属性,这个选项只是以防万一,几乎不会用到。

"preserved_attributes": ["preserved_attr"],

}

`optimize_graph`: 保持 cat 输入输出 scale 一致,目前只有在 Bernoulli 架构下有效。

`hybrid`: 是否使用异��构模式。在以下情况下必须打开异构模式:

1. 模型包含 BPU 不支持的算子或用户希望指定部分 BPU 算子退回 CPU。

2. 用户希望 QAT 模型与 horizon_nn 对接进行定点化。

`hybrid_dict`: 定义用户主动指定的 CPU 算子。

hybrid_dict = {

# 可选,按 module 类型配置

"module_type": [torch.nn.Conv2d, ...],

# 可选,按 module 名配置

"module_name": ["foo.bar", ...],

# 优先级:module_type < module_name

# 与 qconfig_dict 类似,如果想要非 module 类型��的算子运行在 CPU 上,需要将这部分单独封装成 module。

}

"""

horizon_plugin_pytorch.utils.onnx_helper.export_to_onnx

导出 onnx 模型,从而对接 hb_mapper 。

该接口也支持非异构模型,其导出的 ONNX 格式模型仅用于可视化。

def export_to_onnx(

model,

args,

f,

export_params=True,

verbose=False,

training=TrainingMode.EVAL,

input_names=None,

output_names=None,

operator_export_type=OperatorExportTypes.ONNX_FALLTHROUGH,

opset_version=11,

do_constant_folding=True,

example_outputs=None,

strip_doc_string=True,

dynamic_axes=None,

keep_initializers_as_inputs=None,

custom_opsets=None,

enable_onnx_checker=False,

):

"""此接口与 torch.onnx.export 基本一致,隐藏了无需修改的参数,需要的注意参数有:

`model`: 需要 export 的模型

`args`: 模型输入,用于 trace 模型

`f`: 保存的 onnx 文件名或文件描述符

`operator_export_type`: 算子导出类型

1. 对于非异构模型,onnx 仅用于可视化,不需要保证实际可用,使用默认值 OperatorExportTypes.ONNX_FALLTHROUGH

2. 对于异构模型,onnx 需要保证实际可用,使用 None 确保导出的为标准 onnx 算子。

`opset_version`: 只能为 11,horizon_plugin_pytorch 在 opset 11 中注册了特定的映射规则。

注意:如果使用公版 torch.onnx.export,需要确保上述参数设置正确,

并且 import horizon_plugin_pytorch.utils._register_onnx_ops

以向 opset 11 中注册特定的映射规则。

"""

horizon_plugin_pytorch.quantization.convert_fx

异构模式可以复用 convert_fx 把伪量化模型转换成异构量化模型,用于评测模型精度。

通过 convert_fx 得到的异构量化模型无法进行部署。目前仅用于评测模型精度。

def convert_fx(

graph_module: GraphModule,

convert_custom_config_dict: Dict[str, Any] = None,

_remove_qconfig: bool = True,

) -> QuantizedGraphModule:

"""转换 QAT 模型,仅用于评测定点模型。

`graph_module`: 经过 prepare->(calibration)->train 之后的模型

`convert_custom_config_dict`: 自定义配置字典

convert_custom_config_dict = {

# 暂时只支持 preserved_attributes。一般而言会自动保留所有属性,这个选项只是以防万一,几乎不会用到。

"preserved_attributes": ["preserved_attr"],

}

`_remove_qconfig`: convert 之后是否删除 qconfig,一般不会用到

"""

流程和示例

-

改造浮点模型。

-

插入

QuantStub与DeQuantStub,保持与非异构的用法一致。-

如果第一个 op 是

cpu op,那么不需要插入QuantStub。 -

如果最后一个 op 是

cpu op,那么可以不用插入DeQuantStub。

-

-

对于非

module的运算,如果需要单独设置qconfig或指定其运行在 CPU 上,需要将其封装成module,参考示例中的_SeluModule。

-

-

设置

march。 RDK X3 设置bernoulli2, RDK Ultra 设置为bayes, RDK X5 设置为bayes-e。 -

设置

qconfig。保留非异构模式下在module内设置qconfig的配置方式,除此以外,还可以通过prepare_qat_fx接口的qconfig_dict参数传入qconfig,具体用法见接口参数说明。-

对于

BPU op,必须保证有qconfig,如果其输入 op 不为QuantStub,那么还需要保证该输入 op 有activation qconfig。 -

对于

CPU op,qconfig不会对其产生任何影响,但如果后面接BPU op,则必须有qconfig。 -

推荐设置方式:先设置全局

qconfig为horizon.quantization.default_qat_8bit_fake_quant_qconfig(或者horizon.quantization.default_calib_8bit_fake_quant_qconfig,根据 calibration 或 qat 阶段选择) ,在此基础上根据需求修改,一般而言,只需要对 int16 和高精度输出的 op 单独设置qconfig。

-

目前只有BPU架构为 BAYES 的 RDK Ultra 和 BAYES_E 的 RDK X5 支持设置 int16 量化。

-

设置

hybrid_dict。可选,具体用法见接口参数说明,如果没有主动指定的 CPU 算子,可以不设置hybrid_dict。 -

调用

prepare_qat_fx并进行calibration。参考 horizon_plugin_pytorch 开发指南章节中的 Calibration 小节内容。 -

调用

prepare_qat_fx,加载calibration模型并进行 QAT 训练。参考 horizon_plugin_pytorch 开发指南章节中的 量化训练 小节内容。 -

调用

convert_fx。可选,没有评测定点模型精度的需求时可以跳过。 -

调用

export_to_onnx。也可以使用torch.onnx.export但需要遵守export_to_onnx接口说明中的注意事项。 -

使用

hb_mapper转换 onnx 模型。转换后需检查算子是否运行在预期的设备上,在部分情况下,hb_mapper仍然需要设置run_on_cpu参数。比如:虽然conv在 QAT 阶段没有量化,但由于其输入(上一个算子输出)经过了伪量化,hb_mapper仍然会默认将其量化。

import copy

import numpy as np

import torch

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn import qat

from horizon_plugin_pytorch.quantization import (

prepare_qat_fx,

convert_fx,

set_fake_quantize,

FakeQuantState,

load_observer_params,

)

from horizon_plugin_pytorch.quantization.qconfig import (

default_calib_8bit_fake_quant_qconfig,

default_calib_out_8bit_fake_quant_qconfig,

default_qat_8bit_fake_quant_qconfig,

default_qat_out_8bit_fake_quant_qconfig,

)

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

from horizon_plugin_pytorch.utils.onnx_helper import export_to_onnx

class _ConvBlock(nn.Module):

def __init__(self, channels=3):

super().__init__()

self.conv = nn.Conv2d(channels, channels, 1)

self.prelu = torch.nn.PReLU()

def forward(self, input):

x = self.conv(input)

x = self.prelu(x)

return torch.nn.functional.selu(x)

# 封装 functional selu 为 module,便于单独设置

class _SeluModule(nn.Module):

def forward(self, input):

return torch.nn.functional.selu(input)

class HybridModel(nn.Module):

def __init__(self, channels=3):

super().__init__()

# 插入 QuantStub

self.quant = QuantStub()

self.conv0 = nn.Conv2d(channels, channels, 1)

self.prelu = torch.nn.PReLU()

self.conv1 = _ConvBlock(channels)

self.conv2 = nn.Conv2d(channels, channels, 1)

self.conv3 = nn.Conv2d(channels, channels, 1)

self.conv4 = nn.Conv2d(channels, channels, 1)

self.selu = _SeluModule()

# 插入 DequantStub

self.dequant = DeQuantStub()

self.identity = torch.nn.Identity()

def forward(self, input):

x = self.quant(input)

x = self.conv0(x)

x = self.identity(x)

x = self.prelu(x)

x = torch.nn.functional.selu(x)

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.identity(x)

x = self.conv4(x)

x = self.selu(x)

return self.dequant(x)

# 设置 march **RDK X3** 设置BERNOULLI2, **RDK Ultra** 设置为BAYES, **RDK X5** 设置��为BAYES_E。

set_march(March.BAYES)

data_shape = [1, 3, 224, 224]

data = torch.rand(size=data_shape)

model = HybridModel()

qat_model = copy.deepcopy(model)

# float 模型的推理不要放在 prepare_qat_fx 之后,prepare_qat_fx 会对 float 模型做 inplace 修改

float_res = model(data)

calibration_model = prepare_qat_fx(

model,

{

"": default_calib_8bit_fake_quant_qconfig,

# selu 为 cpu 算子,conv4 实际上是 bpu 模型的输出,设置为高精度输出

"module_name": [("conv4", default_calib_out_8bit_fake_quant_qconfig)]

},

hybrid=True,

hybrid_dict={

"module_name": ["conv1.conv", "conv3"],

"module_type": [_SeluModule],

},

)

# calibration 阶段需确保原有模型不会发生变化

calibration_model.eval()

set_fake_quantize(calibration_model, FakeQuantState.CALIBRATION)

for i in range(5):

calibration_model(torch.rand(size=data_shape))

qat_model = prepare_qat_fx(

qat_model,

{

"": default_qat_8bit_fake_quant_qconfig,

# selu 为 cpu 算子,conv4 实际上是 bpu 模型的输��出,设置为高精度输出

"module_name": [("conv4", default_qat_out_8bit_fake_quant_qconfig)]

},

hybrid=True,

hybrid_dict={

"module_name": ["conv1.conv", "conv3"],

"module_type": [_SeluModule],

},

)

load_observer_params(calibration_model, qat_model)

set_fake_quantize(calibration_model, FakeQuantState.QAT)

# qat training start

# ......

# qat training end

# 导出 qat.onnx

export_to_onnx(

qat_model,

data,

"qat.onnx",

operator_export_type=None,

)

# 评测定点模型

quantize_model = convert_fx(qat_model)

quantize_res = quantize_model(data)

打印 QAT 模型的结果。

HybridModel(

(quant): QuantStub(

(activation_post_process): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_tensor_symmetric, ch_axis=-1, scale=tensor([0.0078]), zero_point=tensor([0])

(activation_post_process): MovingAverageMinMaxObserver(min_val=tensor([-0.9995]), max_val=tensor([0.9995]))

)

)

(conv0): Conv2d(

3, 3, kernel_size=(1, 1), stride=(1, 1)

(weight_fake_quant): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_channel_symmetric, ch_axis=0, scale=tensor([0.0038, 0.0041, 0.0016]), zero_point=tensor([0, 0, 0])

(activation_post_process): MovingAveragePerChannelMinMaxObserver(min_val=tensor([-0.4881, -0.4944, 0.0787]), max_val=tensor([-0.1213, 0.5284, 0.1981]))

)

(activation_post_process): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_tensor_symmetric, ch_axis=-1, scale=tensor([0.0064]), zero_point=tensor([0])

(activation_post_process): MovingAverageMinMaxObserver(min_val=tensor([-0.8159]), max_val=tensor([0.8159]))

)

)

(prelu): PReLU(num_parameters=1)

(conv1): _ConvBlock(

(conv): Conv2d(3, 3, kernel_size=(1, 1), stride=(1, 1))

(prelu): PReLU(num_parameters=1)

)

(conv2): Conv2d(

3, 3, kernel_size=(1, 1), stride=(1, 1)

(weight_fake_quant): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_channel_symmetric, ch_axis=0, scale=tensor([0.0040, 0.0044, 0.0040]), zero_point=tensor([0, 0, 0])

(activation_post_process): MovingAveragePerChannelMinMaxObserver(min_val=tensor([-0.5044, -0.4553, -0.5157]), max_val=tensor([0.1172, 0.5595, 0.4104]))

)

(activation_post_process): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_tensor_symmetric, ch_axis=-1, scale=tensor([0.0059]), zero_point=tensor([0])

(activation_post_process): MovingAverageMinMaxObserver(min_val=tensor([-0.7511]), max_val=tensor([0.7511]))

)

)

(conv3): Conv2d(3, 3, kernel_size=(1, 1), stride=(1, 1))

(conv4): Conv2d(

3, 3, kernel_size=(1, 1), stride=(1, 1)

(weight_fake_quant): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_channel_symmetric, ch_axis=0, scale=tensor([0.0025, 0.0037, 0.0029]), zero_point=tensor([0, 0, 0])

(activation_post_process): MovingAveragePerChannelMinMaxObserver(min_val=tensor([-0.2484, -0.4718, -0.3689]), max_val=tensor([ 0.3239, -0.0056, 0.3312]))

)

(activation_post_process): None

)

(selu): _SeluModule()

(dequant): DeQuantStub()

(identity): Identity()

(prelu_input_dequant): DeQuantStub()

(selu_1_activation_post_process): _WrappedCalibFakeQuantize(

(activation_post_process): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_tensor_symmetric, ch_axis=-1, scale=tensor([0.0042]), zero_point=tensor([0])

(activation_post_process): MovingAverageMinMaxObserver(min_val=tensor([-0.5301]), max_val=tensor([0.5301]))

)

)

(conv3_activation_post_process): _WrappedCalibFakeQuantize(

(activation_post_process): FakeQuantize(

fake_quant_enabled=tensor([1], dtype=torch.uint8), observer_enabled=tensor([1], dtype=torch.uint8), quant_min=-128, quant_max=127, dtype=qint8, qscheme=torch.per_tensor_symmetric, ch_axis=-1, scale=tensor([0.0072]), zero_point=tensor([0])

(activation_post_process): MovingAverageMinMaxObserver(min_val=tensor([-0.9156]), max_val=tensor([0.9156]))

)

)

(conv3_input_dequant): DeQuantStub()

(selu_2_input_dequant): DeQuantStub()

)

def forward(self, input):

input_1 = input

quant = self.quant(input_1); input_1 = None

conv0 = self.conv0(quant); quant = None

identity = self.identity(conv0); conv0 = None

prelu_input_dequant_0 = self.prelu_input_dequant(identity); identity = None

prelu = self.prelu(prelu_input_dequant_0); prelu_input_dequant_0 = None

selu = torch.nn.functional.selu(prelu, inplace = False); prelu = None

conv1_conv = self.conv1.conv(selu); selu = None

conv1_prelu = self.conv1.prelu(conv1_conv); conv1_conv = None

selu_1 = torch.nn.functional.selu(conv1_prelu, inplace = False); conv1_prelu = None

selu_1_activation_post_process = self.selu_1_activation_post_process(selu_1); selu_1 = None

conv2 = self.conv2(selu_1_activation_post_process); selu_1_activation_post_process = None

conv3_input_dequant_0 = self.conv3_input_dequant(conv2); conv2 = None

conv3 = self.conv3(conv3_input_dequant_0); conv3_input_dequant_0 = None

conv3_activation_post_process = self.conv3_activation_post_process(conv3); conv3 = None

identity_1 = self.identity(conv3_activation_post_process); conv3_activation_post_process = None

conv4 = self.conv4(identity_1); identity_1 = None

selu_2_input_dequant_0 = self.selu_2_input_dequant(conv4); conv4 = None

selu_2 = torch.nn.functional.selu(selu_2_input_dequant_0, inplace = False); selu_2_input_dequant_0 = None

dequant = self.dequant(selu_2); selu_2 = None

return dequant

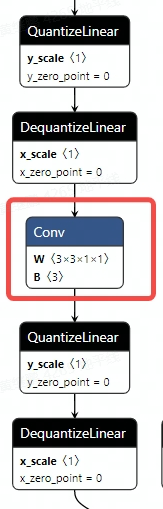

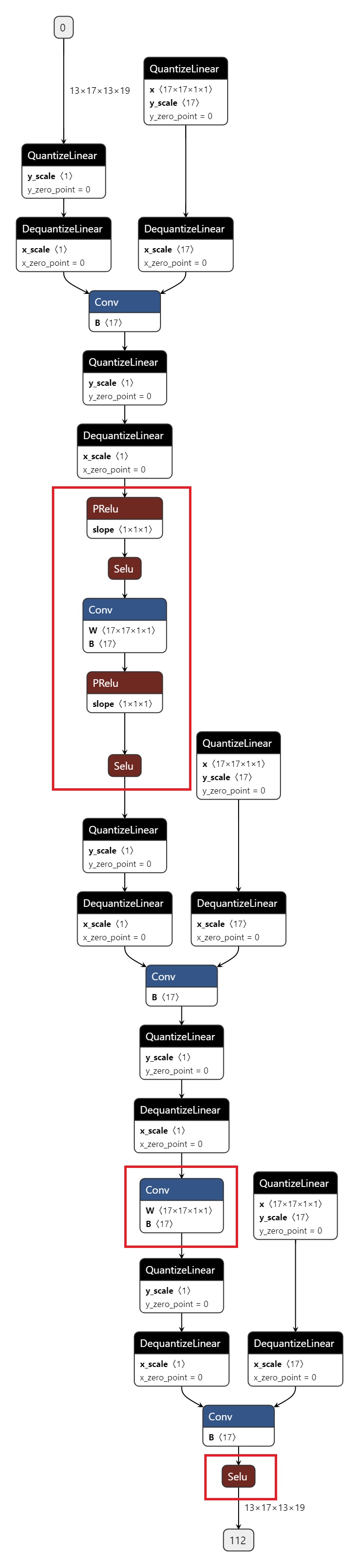

导出的 onnx 如图所示,红色圈出部分为 CPU 算子。

分析工具使用指南

当 QAT 或者定点模型出现精度问题时,您可以使用我们提供的各种工具来分析模型,定位精度掉点问题。

总览

各种工具的使用接口和使用场景总结如下表。除了模型可视化工具,其它工具均在 horizon_plugin_pytorch.utils.quant_profiler 包中。

| 工具 | 使用接口/方式 | 使用场景 |

|---|---|---|

| 集成接口 | model_profiler | 调用其它 debug 工具并将结果集中显示到一个 html 页面; 目前会调用相似度、统计量、共享 op 检查、fuse 检查、weight 比较和量化配置检查这几个工具 |

| fuse 检查 | check_unfused_operations | 检查浮点模型中是否有可以 fuse 但是没有 fuse 的 op pattern |

| 共享 op 检查 | get_module_called_count | 检查模型中是否有共享使用的 op |

| 量化配置检查 | check_qconfig | 检查 QAT 模型中量化配置是否符合预期 |

| 模型可视化 | export_to_onnx export_quantized_onnx | 导出 onnx 模型以查看模型结构,不支持 onnx run |

| 相似度对比 | featuremap_similarity | 当量化模型精度降低时,定位出现问题的 op |

| 统计量 | get_raw_features / profile_featuremap | 输出模型中每一层输出的数值特征,用于评估当前的数据分布��和量化精度是否适合量化 |

| 模型 weight 比较 | compare_weights | 比较模型中每一层 weight 的相似度 |

| 分步量化 | qconfig=None | 当 QAT 模型训练困难时,通过将模型中的某一部分设置为浮点来寻找精度损失的瓶颈 |

| 单算子转换精度调试 | set_preserve_qat_mode | 当出现 QAT 模型转定点精度降低时,通过此接口将定点模型中的部分 op 替换为 QAT 的形式来寻找精度损失的瓶颈 |

| 异构模型部署 device 检查 | check_deploy_device | 检查异构模型部署时每个 op 是否按照预期运行在 BPU 或者 CPU 上 |

| torchscript 和 hbdk 结果对比 | script_profile | 比较 horizon_plugin_pytorch 生成的定点 pt 中每一个 op 和 hbdk 的解析结果是否一致 |

| 不同版本 torchscript 的结果对比 | compare_script_models | 比较相同模型,使用不同版本的 horizon_plugin_pytorch 生成的定点 pt 中每一个 op 的结果 |

| 模型显存占用分析工具 | show_cuda_memory_consumption | 分析模型显存占用情况,定位显存瓶颈 |

集成接口

为方便使用和查看,horizon_plugin_pytorch 提供了一个集成接口 model_profiler,该接口会调用其它 debug 工�具并将结果集中显示到一个 html 页面中,所有其它 debug 工具的结果也会同时保存。目前会调用相似度、统计量、共享 op 检查、fuse 检查、weight 比较和量化配置检查这几个工具。

该接口涉及两个模型之间的比较,fx 模式下,模型转换的过程默认都是 inplace 的,如果需要使用该工具,请您手动在进行转换前 deepcopy 一份原始模型。否则转换后,会错误地比较两个相同模型。

# from horizon_plugin_pytorch.utils.quant_profiler import model_profiler

def model_profiler(

model1: torch.nn.Module,

model2: torch.nn.Module,

example_inputs: Any,

mode: str,

out_dir: Optional[str] = None,

kwargs_dict: Optional[dict] = None,

):

"""运行各种检查分析工具并将结果统一展示到一个 html 页面

该函数会比较:

1)两个模型中各个 op 的相似度,统计量,weight 的相似度,同时检查模型中的共享 op

2)检查浮点模型中是否有未 fuse 的 pattern,检查 QAT 模型的量化配置

结果会统一展示在`profiler.html`中。

注意:

1)该接口仅支持同一个模型的相邻两个阶段,并按转换顺序输入的比较。如`浮点 vs QAT`

或者`QAT vs 定点`。不支持浮点模型直接和定点模型比较,`QAT 模型 vs 浮点模型`这样

的输入顺序也是不支持的。

2)模型结构的 onnx 可视化结果,以及各层 featuremap 的统计直方图并没有在 html 页面中

显示。您可以手动调用`export_to_onnx/export_quantized_onnx`和

`profile_featuremap(with_tensorboard=True)`。此外,该接口也支持通过

`kwargs_dict`参数来传递调用各个 debug 工具时的自定义参数。

参数:

model1: 浮点/校准/QAT模型

model2: 校准/QAT/定点模型

example_inputs: 模型输入

mode:表示进行比较的是哪两个模型,仅支持以下三种模式

- `FvsQ`:float 模型和 qat/calibration 模型对比

- `QvsQ`:qat 模型和 quantized 模型对比

- `CvsQ`:calibration 模型和 qat 模型对比

out_dir:指定输出的结果文件`profiler.html`和所有 debug 工具调用结果的路径。默认

为`None`,会在`ckpt_dir`指定的目录下或当前目录下生成`profiler`目录,并将所有

结果存储在该目录下。

kwargs_dict:调用其他 debug 工具时的参数,以`dict`的形式给出。**具体的参数可以

参考上面每个工具的具体介绍**。支持 7 个 key 值

1)`featuremap_similarity`:相似度

2)`get_raw_features`:计算每一层 op 输入输出 feature 的相关特征

3)`profile_featuremap`:统计量函数,输出模型中每一层结果的最大最小值,均

值和方差等

4)`get_module_called_count`:检查模型是否有共享 op

5)`check_unfused_operations`:检查模型是否有未 fuse 的 pattern

6)`compare_weights`:比较两个模型中 weight 的相似度

7)`check_qconfig`:检查 QAT 模型中的 Qconfig 配置

注意:

1) `model`和`example_inputs`两个参数已在`model_profiler`接口中定

义,kwargs_dict 中必须没有这两个参数的定义

2) kwargs_dict 中的`out_dir`参数会被`model_profiler`接口中的

`out_dir`参数替换

"""

使用示例:

from copy import deepcopy

import numpy as np

import pytest

import torch

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

import horizon_plugin_pytorch as horizon

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.qat_mode import QATMode, set_qat_mode

from horizon_plugin_pytorch.quantization import (

convert_fx,

prepare_qat_fx,

)

from horizon_plugin_pytorch.quantization.qconfig import (

default_qat_8bit_fake_quant_qconfig,

)

from horizon_plugin_pytorch.utils.quant_profiler import model_profiler

class Conv2dModule(nn.Module):

def __init__(

self,

in_channels,

out_channels,

kernel_size=1,

stride=1,

padding=0,

dilation=1,

groups=1,

bias=True,

padding_mode="zeros",

):

super().__init__()

self.conv2d = nn.Conv2d(

in_channels,

out_channels,

kernel_size,

stride,

padding,

dilation,

groups,

bias,

padding_mode,

)

self.add = FloatFunctional()

self.bn_mod = nn.BatchNorm2d(out_channels)

self.relu_mod = nn.ReLU()

def forward(self, x, y):

x = self.conv2d(x)

x = self.bn_mod(x)

x = self.add.add(x, y)

x = self.relu_mod(x)

return x

class TestFuseNet(nn.Module):

def __init__(self, channels) -> None:

super().__init__()

self.quantx = QuantStub()

self.quanty = QuantStub()

self.convmod1 = Conv2dModule(channels, channels)

self.convmod2 = Conv2dModule(channels, channels)

self.convmod3 = Conv2dModule(channels, channels)

self.shared_conv = nn.Conv2d(channels, channels, 1)

self.bn1 = nn.BatchNorm2d(channels)

self.bn2 = nn.BatchNorm2d(channels)

self.sub = FloatFunctional()

self.relu = nn.ReLU()

self.dequant = DeQuantStub()

def forward(self, x, y):

x = self.quantx(x)

y = self.quanty(y)

x = self.convmod1(x, y)

x = self.convmod2(y, x)

x = self.convmod3(x, y)

x = self.shared_conv(x)

x = self.bn1(x)

y = self.shared_conv(y)

y = self.bn2(y)

x = self.sub.sub(x, y)

x = self.relu(x)

return self.dequant(x)

# **RDK X3** 设置BERNOULLI2, **RDK Ultra** 设置为BAYES, **RDK X5** 设置为BAYES_E。

set_march(March.BAYES)

device = torch.device("cpu")

data = torch.arange(1 * 3 * 4 * 4) / 100 + 1

data = data.reshape((1, 3, 4, 4))

data = data.to(torch.float32).to(device)

float_net = TestFuseNet(3).to(device)

float_net(data, data)

qat_net = prepare_qat_fx(float_net, {"": default_qat_8bit_fake_quant_qconfig})

qat_net = qat_net.to(device)

qat_net(data, data)

# fx 模式下,需要 deepcopy 转换前的模型

qat_net2 = deepcopy(qat_net)

quantized_net = convert_fx(qat_net2)

model_profiler(qat_net, quantized_net, (data, data), mode="QvsQ")

若没有指定out_dir参数,则会在当前目录下生成horizon_quant_debug文件夹,profiler.html和各个 debug 工具的运行结果均会保存到该文件夹下。每个 debug 工具的输出详解请参考下列各个工具的具体介绍。

fuse 检查

模型 fuse 的正确性包含两方面:

- 可以 fuse 的算子是否都 fuse 了。

- 已经 fuse 的算子是否正确。

该接口只能对第一种情况进行检查,对于第二种情况,请使用相似度对比工具对 fuse 前后模型的 feature 相似度进行对比,若发现从某一个算子之后所有 feature 的相似度都有问题,则这个算子的 fuse 可能是错误的(fuse 过程会将几个 op 合并为一个,其他位置用 Identity 代替,因此在这些 Identity 的位置出现 feature 相似度低的情况可能是正常的)。

该接口仅接受浮点模型输入。

# from horizon_plugin_pytorch.utils.quant_profiler import check_unfused_operations

def check_unfused_operations(

model: torch.nn.Module,

example_inputs,

print_tabulate=True,

):

"""检查模型中是否有可融合但是未融合的 op。

该接口只能检查是否有未融合的 op。不能检查融合的正确性,若要检查 op 融合是否正确,

请使用`featuremap_similarity`接口比较 fuse 前后两个模型的相似度。

参数:

model:输入模型

example_inputs:模型输入参数

print_tabulate:是否打印结果。默认为 True。

输出:

List[List[str]]:可融合的 op pattern 列表

"""

使用示例:

该示例为 eager 模式下的示例(手动定义 fuse pattern 并调用 fuse 函数)。若使用 fx 进行量化,会自动对模型中所有可以 fuse 的 pattern 做 fuse 操作。

import horizon_plugin_pytorch as horizon

import numpy as np

import torch

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.utils.quant_profiler import check_unfused_operations

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

class Conv2dModule(nn.Module):

def __init__(

self,

in_channels,

out_channels,

kernel_size=1,

stride=1,

padding=0,

dilation=1,

groups=1,

bias=True,

padding_mode="zeros",

):

super().__init__()

self.conv2d = nn.Conv2d(

in_channels,

out_channels,

kernel_size,

stride,

padding,

dilation,

groups,

bias,

padding_mode,

)

self.add = FloatFunctional()

self.bn_mod = nn.BatchNorm2d(out_channels)

self.relu_mod = nn.ReLU()

def forward(self, x, y):

x = self.conv2d(x)

x = self.bn_mod(x)

x = self.add.add(x, y)

x = self.relu_mod(x)

return x

def fuse_model(self):

from horizon_plugin_pytorch.quantization import fuse_modules

fuse_list = ["conv2d", "bn_mod", "add", "relu_mod"]

fuse_modules(

self,

fuse_list,

inplace=True,

)

class TestFuseNet(nn.Module):

def __init__(self, channels) -> None:

super().__init__()

self.convmod1 = Conv2dModule(channels, channels)

self.convmod2 = Conv2dModule(channels, channels)

self.convmod3 = Conv2dModule(channels, channels)

self.shared_conv = nn.Conv2d(channels, channels, 1)

self.bn1 = nn.BatchNorm2d(channels)

self.bn2 = nn.BatchNorm2d(channels)

self.sub = FloatFunctional()

self.relu = nn.ReLU()

def forward(self, x, y):

x = self.convmod1(x, y)

x = self.convmod2(y, x)

x = self.convmod3(x, y)

x = self.shared_conv(x)

x = self.bn1(x)

y = self.shared_conv(y)

y = self.bn2(y)

x = self.sub.sub(x, y)

x = self.relu(x)

return x

def fuse_model(self):

self.convmod1.fuse_model()

self.convmod3.fuse_model()

shape = np.random.randint(10, 20, size=4).tolist()

data0 = torch.rand(size=shape)

data1 = torch.rand(size=shape)

float_net = TestFuseNet(shape[1])

float_net.fuse_model()

check_unfused_operations(float_net, (data0, data1))

输出结果如下:

name type

------------------- ------------------------------------------------

shared_conv(shared) <class 'torch.nn.modules.conv.Conv2d'>

bn1 <class 'torch.nn.modules.batchnorm.BatchNorm2d'>

name type

------------------- ------------------------------------------------

shared_conv(shared) <class 'torch.nn.modules.conv.Conv2d'>

bn2 <class 'torch.nn.modules.batchnorm.BatchNorm2d'>

name type

----------------- --------------------------------------------------------------------------------

convmod2.conv2d <class 'torch.nn.modules.conv.Conv2d'>

convmod2.bn_mod <class 'torch.nn.modules.batchnorm.BatchNorm2d'>

convmod2.add <class 'horizon_plugin_pytorch.nn.quantized.functional_modules.FloatFunctional'>

convmod2.relu_mod <class 'torch.nn.modules.activation.ReLU'>

每一组可以 fuse 但是未 fuse 的 pattern 都会以表格的形式输出,第一列为 module 在模型中定义的 name,第二列为 module 的类型。

共享 op 检查

此接口统计并打印模型在一次 forward 过程中每个 op 被调用的次数,以此检查模型中是否存在共享 op。若一个 module 实例在模型中以不同的名字出现了多次,函数会使用第一个名字,且将所有的调用记在这个名字上(您可以看到相关警告)。

# from horizon_plugin_pytorch.utils.quant_profiler import get_module_called_count

def get_module_called_count(

model: torch.nn.Module,

example_inputs,

check_leaf_module: callable = None,

print_tabulate: bool = True,

) -> Dict[str, int]:

"""计算模型中叶子节点的调用次数

参数:

model:模型

example_inputs:模型输入

check_leaf_module:检查 module 是否是一个叶子节点。默认为 None,使用预定义的

is_leaf_module,将所有 horizon_plugin_pytorch 中定义的 op 以及未支持的浮点 op 当作为叶子节点。

print_tabulate:是否打印结果。默认为 True。

输出:

Dict[str, int]:模型中每一层的 name 以及对应的调用次数。

"""

使用示例:

import numpy as np

import torch

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

import horizon_plugin_pytorch as horizon

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.utils.quant_profiler import get_module_called_count

class Net(nn.Module):

def __init__(self, quant=False, share_op=True):

super(Net, self).__init__()

self.quant_stubx = QuantStub()

self.quant_stuby = QuantStub()

self.mul_op = FloatFunctional()

self.cat_op = FloatFunctional()

self.quantized_ops = nn.Sequential(

nn.ReLU(),

nn.Sigmoid(),

nn.Softmax(),

nn.SiLU(),

horizon_nn.Interpolate(

scale_factor=2, recompute_scale_factor=True

),

horizon_nn.Interpolate(

scale_factor=2.3, recompute_scale_factor=True

),

nn.AvgPool2d(kernel_size=4),

nn.Upsample(scale_factor=1.3, mode="bilinear"),

nn.UpsamplingBilinear2d(scale_factor=0.7),

)

self.dequant_stub = DeQuantStub()

self.float_ops = nn.Sequential(

nn.Tanh(),

nn.LeakyReLU(),

nn.PReLU(),

nn.UpsamplingNearest2d(scale_factor=0.7),

)

self.quant = quant

self.share_op = share_op

def forward(self, x, y):

x = self.quant_stubx(x)

y = self.quant_stuby(y)

z = self.mul_op.mul(x, y)

x = self.cat_op.cat((x, y), dim=1)

if self.share_op:

x = self.cat_op.cat((x, y), dim=1)

x = self.quantized_ops(x)

x = self.dequant_stub(x)

if not self.quant:

x = self.float_ops(x)

return x

shape = np.random.randint(10, 20, size=4).tolist()

data0 = torch.rand(size=shape)

data1 = torch.rand(size=shape)

float_net = Net()

get_module_called_count(float_net, (data0, data1))

输出为一个表格,记录了模型中每个 module 的调用次数。正常情况下,每个 module 均调用 1 次;若为 0 ��次,则说明该 module 定义了但未被使用;若大于 1 次,则说明该 module 被共享使用了多次:

name called times

--------------- --------------

quant_stubx 1

quant_stuby 1

unused 0

mul_op 1

cat_op 2

quantized_ops.0 1

quantized_ops.1 1

quantized_ops.2 1

quantized_ops.3 1

quantized_ops.4 1

quantized_ops.5 1

quantized_ops.6 1

quantized_ops.7 1

quantized_ops.8 1

dequant_stub 1

float_ops.0 1

float_ops.1 1

float_ops.2 1

float_ops.3 1

量化配置检查

检查 calibration/QAT 模型中每一层 op 的量化配置。 输入必须为 QAT 或 calibration 模型 。输出结果会保存到 qconfig_info.txt 文件。

# from horizon_plugin_pytorch.utils.quant_profiler import check_qconfig

def check_qconfig(

model: torch.nn.Module,

example_inputs: Any,

prefixes: Tuple = (),

types: Tuple = (),

custom_check_func: Optional[Callable] = None,

out_dir: Optional[str] = None,

):

"""检查 calibration/QAT 模型量化配置。

该函数会

1)检查模型中每一层的输出 activation 和 weight 的量化配置。配置信息会保存在

`qconfig_info.txt`中。

2)检查模型中每一层的输入输出类型

默认情况下,函数在检查到下列情况时会打印提示信息。

1)输出层 activation 没有量化

2)固定 scale

3)非 int8 量化的 weight(目前仅支持 int8 量化的 weight)

4)模型输入输出类型不一样

如果要检查更多的信息,您可以通过`custom_check_func`传入自定义的检查函数

参数:

model:输入模型,必须为 qat 模型

example_inputs:模型输入

prefixes:指定要检查量化配置的 op 在模型中对应的 layer name(以 prefixes 开

头的 layer)

types:指定要检查量化配置的 op 的类型

custom_check_func:自定义函数,用于检查其他信息。这个函数在 module 的 hook

中调用,因此需要定义为如下格式:

func(module, input, output) -> None

out_dir:保存结果文件`qconfig_info.txt`的路径。若为 None,则默认保存在当前

路径。

"""

使用示例:

import numpy as np

import torch

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.dtype import qint16

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.quantization import get_default_qconfig

from horizon_plugin_pytorch.quantization.qconfig import (

default_qat_8bit_fake_quant_qconfig,

)

from horizon_plugin_pytorch.quantization.quantize_fx import (

convert_fx,

prepare_qat_fx,

)

from horizon_plugin_pytorch.quantization.observer import FixedScaleObserver

from horizon_plugin_pytorch.utils.quant_profiler import check_qconfig

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

class Conv2dModule(nn.Module):

def __init__(

self,

in_channels,

out_channels,

kernel_size=1,

stride=1,

padding=0,

dilation=1,

groups=1,

bias=True,

padding_mode="zeros",

):

super().__init__()

self.conv2d = nn.Conv2d(

in_channels,

out_channels,

kernel_size,

stride,

padding,

dilation,

groups,

bias,

padding_mode,

)

self.add = FloatFunctional()

self.bn_mod = nn.BatchNorm2d(out_channels)

self.relu_mod = nn.ReLU()

def forward(self, x, y):

x = self.conv2d(x)

x = self.bn_mod(x)

x = self.add.add(x, y)

x = self.relu_mod(x)

return x

class TestFuseNet(nn.Module):

def __init__(self, channels) -> None:

super().__init__()

self.convmod1 = Conv2dModule(channels, channels)

self.convmod2 = Conv2dModule(channels, channels)

self.convmod3 = Conv2dModule(channels, channels)

self.shared_conv = nn.Conv2d(channels, channels, 1)

self.bn1 = nn.BatchNorm2d(channels)

self.bn2 = nn.BatchNorm2d(channels)

self.sub = FloatFunctional()

self.relu = nn.ReLU()

def forward(self, x, y):

x = self.convmod1(x, y)

x = self.convmod2(y, x)

x = self.convmod3(x, y)

x = self.shared_conv(x)

x = self.bn1(x)

y = self.shared_conv(y)

y = self.bn2(y)

x = self.sub.sub(x, y)

x = self.relu(x)

return x

float_net = TestFuseNet(3)

# **RDK X3** 设置BERNOULLI2, **RDK Ultra** 设置为BAYES, **RDK X5** 设置为BAYES_E。

set_march(March.BAYES)

# 手动构造不支持的或特殊的 cases

sub_qconfig = get_default_qconfig(

# 固定 sub 的输出 scale

activation_qkwargs={

"observer": FixedScaleObserver,

"scale": 1 / 2 ** 15,

"dtype": qint16,

}

)

qat_net = prepare_qat_fx(

float_net,

{

"": get_default_qconfig(

weight_qkwargs={

"qscheme": torch.per_channel_symmetric,

"ch_axis": 0,

# 不支持 weight 的 int16 量化

"dtype": qint16,

}

),

"module_name": [("sub", sub_qconfig)]

}

)

shape = np.random.randint(10, 20, size=4).tolist()

shape[1] = 3

data0 = torch.rand(size=shape)

data1 = torch.rand(size=shape)

check_qconfig(qat_net, (data0, data1))

输出结果:

-

qconfig_info.txt

Each layer out qconfig:

+-------------------+----------------------------------------------------------------------------+--------------------+-------------+----------------+

| Module Name | Module Type | Input dtype | out dtype | ch_axis |

|-------------------+----------------------------------------------------------------------------+--------------------+-------------+----------------|

| quantx | <class 'horizon_plugin_pytorch.nn.qat.stubs.QuantStub'> | torch.float32 | qint8 | -1 |

| quanty | <class 'horizon_plugin_pytorch.nn.qat.stubs.QuantStub'> | torch.float32 | qint8 | -1 |

| convmod1.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | ['qint8', 'qint8'] | qint8 | -1 |

| convmod2.conv2d | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint8 | qint8 | -1 |

| convmod2.bn_mod | <class 'horizon_plugin_pytorch.nn.qat.batchnorm.BatchNorm2d'> | qint8 | qint8 | -1 |

| convmod2.add[add] | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | ['qint8', 'qint8'] | qint8 | -1 |

| convmod2.relu_mod | <class 'horizon_plugin_pytorch.nn.qat.relu.ReLU'> | qint8 | qint8 | qconfig = None |

| convmod3.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | ['qint8', 'qint8'] | qint8 | -1 |

| shared_conv | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint8 | qint8 | -1 |

| bn1 | <class 'horizon_plugin_pytorch.nn.qat.batchnorm.BatchNorm2d'> | qint8 | qint8 | -1 |

| shared_conv(1) | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint8 | qint8 | -1 |

| bn2 | <class 'horizon_plugin_pytorch.nn.qat.batchnorm.BatchNorm2d'> | qint8 | qint8 | -1 |

| sub[sub] | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | ['qint8', 'qint8'] | qint16 | -1 |

| relu | <class 'horizon_plugin_pytorch.nn.qat.relu.ReLU'> | qint16 | qint16 | qconfig = None |

+-------------------+----------------------------------------------------------------------------+--------------------+-------------+----------------+

Weight qconfig:

+-----------------+--------------------------------------------------------------+----------------+-----------+

| Module Name | Module Type | weight dtype | ch_axis |

|-----------------+--------------------------------------------------------------+----------------+-----------|

| convmod1.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 | 0 |

| convmod2.conv2d | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 | 0 |

| convmod3.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 | 0 |

| shared_conv | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 | 0 |

| shared_conv(1) | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 | 0 |

+-----------------+--------------------------------------------------------------+----------------+-----------+

Please check if these OPs qconfigs are expected..

+-----------------+----------------------------------------------------------------------------+------------------------------------------------------------------+

| Module Name | Module Type | Msg |

|-----------------+----------------------------------------------------------------------------+------------------------------------------------------------------|

| convmod1.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 weight!!! |

| convmod2.conv2d | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 weight!!! |

| convmod3.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 weight!!! |

| shared_conv | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 weight!!! |

| shared_conv(1) | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 weight!!! |

| sub[sub] | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | input dtype ['qint8', 'qint8'] is not same with out dtype qint16 |

| sub[sub] | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | Fixed scale 3.0517578125e-05 |

+-----------------+----------------------------------------------------------------------------+------------------------------------------------------------------+输出的 txt 文件中保存了三个表格,按照从上到下的顺序,每个表格的含义如下:

-

每一层输出的量化信息,从左到右每一列分别表示:

- Module Name:每个 module 在模型中定义的 name

- Module Type:每个 module 的实际类型

- Input dtype:每个 module 的输入类型

- out dtype:每个 module 的输出类型

- ch_axis:在哪一维度上进行量化。-1 表示 per-tensor 量化;若显示 qconfig=None,则说明该 module 没有配置 qconfig,不会进行量化操作

-

每一层中 weight 的量化信息,从左到右每一列分��别表示:

- Module Name:每个 module 在模型中定义的 name

- Module Type:每个 module 的实际类型

- weight dtype:对 weight 采用的何种量化精度,目前仅支持 qint8 量化

- ch_axis:在哪一维度上进行量化。-1 表示 per-tensor 量化;默认 weight 均在第 0 维上量化,若显示 qconfig=None,则说明该 module 的 weight 没有配置 qconfig,不会进行量化操作

-

模型中特殊量化配置的 module(并不表示配置错误,需要逐个检查)。该表格也会在屏幕上输出。

- Module Name:每个 module 在模型中定义的 name

- Module Type:每个 module 的实际类型

- Msg:特殊的量化配置

-

-

屏幕输出

Please check if these OPs qconfigs are expected..

+---------------+----------------------------------------------------------------------------+------------------------------------------------------------------+

| Module Name | Module Type | Msg |

|---------------+----------------------------------------------------------------------------+------------------------------------------------------------------|

| convmod1.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 weight!!! |

| convmod2.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 weight!!! |

| convmod3.add | <class 'horizon_plugin_pytorch.nn.qat.conv2d.ConvAddReLU2d'> | qint16 weight!!! |

| bn1 | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 weight!!! |

| shared_conv | <class 'horizon_plugin_pytorch.nn.qat.conv2d.Conv2d'> | qint16 weight!!! |

| sub | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | input dtype ['qint8', 'qint8'] is not same with out dtype qint16 |

| sub | <class 'horizon_plugin_pytorch.nn.qat.functional_modules.FloatFunctional'> | Fixed scale 3.0517578125e-05 |

+---------------+----------------------------------------------------------------------------+------------------------------------------------------------------+

可视化:ONNX 模型可视化

目前 horizon_plugin_pytorch 支持任意阶段的模型可视化。这里的可视化指的是可视化模型结构,默认导出 onnx,可以使用 netron 查看。目前导出的 onnx 不支持推理,仅支持可视化查看模型结构。

# from horizon_plugin_pytorch.utils.onnx_helper import (

# export_to_onnx,

# export_quantized_onnx,

# )

export_to_onnx(

model,

args,

f,

export_params=True,

verbose=False,

training=TrainingMode.EVAL,

input_names=None,

output_names=None,

operator_export_type=OperatorExportTypes.ONNX_FALLTHROUGH,

do_constant_folding=True,

example_outputs=None,

dynamic_axes=None,

enable_onnx_checker=False,

)

export_quantized_onnx(

model,

args,

f,

export_params=True,

verbose=False,

training=TrainingMode.EVAL,

input_names=None,

output_names=None,

operator_export_type=OperatorExportTypes.ONNX_FALLTHROUGH,

opset_version=None,

do_constant_folding=True,

example_outputs=None,

dynamic_axes=None,

keep_initializers_as_inputs=None,

custom_opsets=None,

)

参数的含义和 torch.onnx.export 保持一致,唯一的区别是参数operator_export_type=OperatorExportTypes.ONNX_FALLTHROUGH 。

使用时需注意:

-

浮点模型和 QAT 模型导出 onnx 请使用

export_to_onnx。 -

定点模型导出 onnx 请使用

export_quantized_onnx。 -

可视化的粒度为

-

horizon_plugin_pytorch 中自定义的 op,包括浮点 op 和定点 op,op 内部的实现不会被可视化。

-

浮点模型中使用的社区 op 的可视化粒度由社区决定。

-

使用示例:

from copy import deepcopy

import torch

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

import horizon_plugin_pytorch as horizon

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.quantization.quantize_fx import (

convert_fx,

prepare_qat_fx,

)

from horizon_plugin_pytorch.quantization.qconfig import (

default_qat_8bit_fake_quant_qconfig,

)

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.utils.onnx_helper import (

export_to_onnx,

export_quantized_onnx,

)

class Net(nn.Module):

def __init__(self, quant=False, share_op=True):

super(Net, self).__init__()

self.quant_stubx = QuantStub()

self.quant_stuby = QuantStub()

self.mul_op = FloatFunctional()

self.cat_op = FloatFunctional()

self.quantized_ops = nn.Sequential(

nn.ReLU(),

nn.Sigmoid(),

nn.Softmax(),

nn.SiLU(),

horizon_nn.Interpolate(

scale_factor=2, recompute_scale_factor=True

),

horizon_nn.Interpolate(

scale_factor=2.3, recompute_scale_factor=True

),

nn.AvgPool2d(kernel_size=4),

nn.Upsample(scale_factor=1.3, mode="bilinear"),

nn.UpsamplingBilinear2d(scale_factor=0.7),

)

self.dequant_stub = DeQuantStub()

self.float_ops = nn.Sequential(

nn.Tanh(),

nn.LeakyReLU(),

nn.PReLU(),

nn.UpsamplingNearest2d(scale_factor=0.7),

)

self.quant = quant

self.share_op = share_op

def forward(self, x, y):

x = self.quant_stubx(x)

y = self.quant_stuby(y)

z = self.mul_op.mul(x, y)

x = self.cat_op.cat((x, y), dim=1)

if self.share_op:

x = self.cat_op.cat((x, y), dim=1)

x = self.quantized_ops(x)

x = self.dequant_stub(x)

if not self.quant:

x = self.float_ops(x)

return x

# **RDK X3** 设置BERNOULLI2, **RDK Ultra** 设置为BAYES, **RDK X5** 设置为BAYES_E。

set_march(March.BAYES)

device = torch.device("cuda")

float_net = Net(quant=True, share_op=True).to(device)

float_net2 = deepcopy(float_net)

qat_net = prepare_qat_fx(

float_net2, {"": default_qat_8bit_fake_quant_qconfig}

)

qat_net(data, data)

qat_net2 = deepcopy(qat_net)

quantized_net = convert_fx(qat_net2)

data = torch.arange(1 * 3 * 4 * 4) / 100 + 1

data = data.reshape((1, 3, 4, 4))

data = data.to(torch.float32).to(device)

export_to_onnx(float_net, (data, data), "float_test.onnx")

export_to_onnx(qat_net, (data, data), "qat_test.onnx")

export_quantized_onnx(quantized_net, (data, data), "quantized_test.onnx")

相似度对比

当出现定点模型相比 QAT 模型精度下降较多的情况时,可以使用相似度对比工具比较模型中每一层输出的相似度,快速定位到是哪一个 op 导致的精度下降。

-

若某一层的输出全为0,使用余弦相似度计算时相似度结果也是0。此时可以检查一下该层输出是否为全0,或者根据打印的

atol等指标确认一下输出是否相同。若某一层的输出完全相同,使用信噪比��计算相似度时结果为inf; -

若

device=None,工具不会做模型和输入数据的搬运,需要您手动保证模型和模型输入均在同一个device上; -

支持任意两阶段的模型以任意输入顺序,在任意两个

device上比较相似度。推荐按照float/qat/quantized的顺序输入,比如(float,qat)(qat,quantized)这样。如果是(qat,float)的顺序,对相似度和单算子误差没有影响,但是结果中相同输入下的单算子误差项可能会有偏差,因为无法生成和 float 模型完全对应的输入给 QAT 模型。此外,因为 QAT 训练之后,模型参数会改变,所以直接比较 float 和训练之后的 QAT 模型的相似度参考意义不大,建议比较 float 和经过 calibration 之后且未训练的 QAT 模型的相似度; -

fx 模式下,模型转换的过程默认都是 inplace 的,如果需要使用相似度工具,请您手动在进行转换前 deepcopy 一份原始模型。否则转换后,会错误地比较两个相同模型的相似度。

# from horizon_plugin_pytorch.utils.quant_profiler import featuremap_similarity

def featuremap_similarity(

model1: torch.nn.Module,

model2: torch.nn.Module,

inputs: Any,

similarity_func: Union[str, Callable] = "Cosine",

threshold: Optional[Real] = None,

devices: Union[torch.device, tuple, None] = None,

out_dir: Optional[str] = None,

)

"""

相似度对比函数,计算并对比两个输入模型中每一层输出特征的相似度。输入模型可以是

浮点模型、算子融合后的模型、校准模型、QAT 模型或者定点模型。

参数:

model1:可以是浮点模型、算子融合后的模型、校准模型、QAT 模型或者定点模型

model2:可以是浮点模型、算子融合后的模型、校准模型、QAT 模型或者定点模型

inputs:模型输入

similarity_func:计算相似度的方法。默认为余弦相似度 Cosine。支持 Cosine/

MSE/L1/KL/SQNR/自定义的相似度计算函数。如果是自定义相似度函数,最好返回一个

常量或者仅有一个数值的 tensor,否则显示的结果可能不符合预期。

threshold:阈值。默认为 None,会根据不同的相似度计算函数设置成不同的默认阈值。

如果您传进一个数值,按照相似度比较方法的不同,超过或者小于该阈值的值和对应

op 的相似度信息会在屏幕打印。

devices:指定计算相似度时模型在哪个 device 上进行 forward。若为 None,则默认在模

型输入时的 device 上进行 forward;若仅有一个参数如 torch.device("cpu"),则

会把两个模型均移动到指定的 device 上 forward;若指定了两个值如

(torch.device("cpu"), torch.device("cuda")),则会把两个模型分别移动到

对应的 device 上 forward。一般用于比较同一个模型同一个阶段的 CPU/GPU 的中间结果。

out_dir: 指定输出的结果文件和图片的路径。默认为 None,保存到当前路径。

输出:

输出为一个列表,列表中每一项都是一个子列表,每个子列表代表每一层的相似度信息,

格式为 [索引,模块名,模块类型,相似度,输出值的 scale,最大误差,

单算子误差(N scale),相同输入时输出的单算子误差(N scale)]

"""

使用示例:

from copy import deepcopy

import torch

from torch import nn

from torch.quantization import DeQuantStub, QuantStub

import horizon_plugin_pytorch as horizon

from horizon_plugin_pytorch import nn as horizon_nn

from horizon_plugin_pytorch.quantization.quantize_fx import (

convert_fx,

prepare_qat_fx,

)

from horizon_plugin_pytorch.quantization.qconfig import (

default_qat_8bit_fake_quant_qconfig,

)

from horizon_plugin_pytorch.march import March, set_march

from horizon_plugin_pytorch.nn.quantized import FloatFunctional

from horizon_plugin_pytorch.utils.quant_profiler import featuremap_similarity

class Net(nn.Module):

def __init__(self, quant=False, share_op=True):

super(Net, self).__init__()

self.quant_stubx = QuantStub()

self.quant_stuby = QuantStub()

self.mul_op = FloatFunctional()

self.cat_op = FloatFunctional()

self.quantized_ops = nn.Sequential(

nn.ReLU(),

nn.Sigmoid(),

nn.Softmax(),

nn.SiLU(),

horizon_nn.Interpolate(

scale_factor=2, recompute_scale_factor=True

),

horizon_nn.Interpolate(

scale_factor=2.3, recompute_scale_factor=True

),

nn.AvgPool2d(kernel_size=4),

nn.Upsample(scale_factor=1.3, mode="bilinear"),

nn.UpsamplingBilinear2d(scale_factor=0.7),

)

self.dequant_stub = DeQuantStub()

self.float_ops = nn.Sequential(

nn.Tanh(),

nn.LeakyReLU(),

nn.PReLU(),

nn.UpsamplingNearest2d(scale_factor=0.7),

)

self.quant = quant

self.share_op = share_op

def forward(self, x, y):

x = self.quant_stubx(x)

y = self.quant_stuby(y)

z = self.mul_op.mul(x, y)

x = self.cat_op.cat((x, y), dim=1)

if self.share_op:

x = self.cat_op.cat((x, y), dim=1)

x = self.quantized_ops(x)

x = self.dequant_stub(x)

if not self.quant:

x = self.float_ops(x)

return x

# **RDK X3** 设置BERNOULLI2, **RDK Ultra** 设置为BAYES, **RDK X5** 设置为BAYES_E。

set_march(March.BAYES)

device = torch.device("cuda")

float_net = Net(quant=True, share_op=True).to(device)

# fx 均为 inplace 的修改,如果需要比较相似度,需要手动将模型 deepcopy 一份再进行转换

float_net2 = deepcopy(float_net)

qat_net = prepare_qat_fx(

float_net2, {"": default_qat_8bit_fake_quant_qconfig}

)

qat_net(data, data)

qat_net2 = deepcopy(qat_net)

bpu_net = convert_fx(qat_net2)

data = torch.arange(1 * 3 * 4 * 4) / 100 + 1

data = data.reshape((1, 3, 4, 4))

data = data.to(torch.float32).to(device)

featuremap_similarity(qat_net, bpu_net, (data, data))

运行后会在当前目录或者 out_dir 参数指定的目录下生成如下文件:

-

similarity.txt:以表格的形式,按照模型

forward的顺序打印每一层的相似度和单算子误差等结果,表格中从左到右每一列分别为:-

Index:索引,按照模型 forward 顺序,从 0 开始为模型中每一个 op 编号。无实际意义,用于相似度图像中的横轴编号;

-

Module Name:该 op 在模型中定义使用的名字,如 backbone.mod1.conv;不同格式的后缀代理了不同的含义:

-

若模块名有后缀'(I)',表示该 op 在某一个模型中为

Identity; -

若模块名有后缀'(I vs I)',表示该 op 在比较的两个模型中均为

Identity; -

若模块名有后缀'(i)' (i >= 1),表示该层为共享 op,且被共享了 i 次,目前是第 i+1 次调用。共享 op 第 1 次被调用时和其他 op 一样,不带后缀。

-

-